研究方法與實作架構

結合CLIP ViT-H/14 與 LLaMA-3模型之白血球分類系統設計

研究目的

本研究旨在建立一套結合多模態深度學習技術之白血球影像分類系統,藉由 CLIP 與 LLaMA 架構實現語意驅動的分類方式。 透過與傳統純影像分類模型之比較,驗證語意配對技術在醫療影像辨識中之可行性與優勢。 此外,本研究亦嘗試解決醫療影像資料樣本不足問題,提升在臨床應用上的實用性與推廣潛力。

研究方法

本研究主要分為以下步驟:

- 蒐集來自桃園醫院檢驗科的14類白血球臨床影像,並進行標註與前處理。

- 針對資料不平衡問題,導入 Diffusion-GAN 技術生成模擬影像以補足樣本數。

- 建置 CLIP-LLaMA 架構,將影像與文字描述進行語意配對,訓練模型進行分類。

- 透過 APP 實作血液細胞影像即時上傳與辨識系統,並與三位國家認證臨床專家結果比對驗證系統效能。

技術架構

核心技術

- CLIP ViT-H/14:基礎視覺-語言模型,進行白血球細胞分類微調

- LLaMA-3-8B:大型語言模型,生成醫學描述文本

- Diffusion-GAN:資料增補技術,解決樣本不足問題

- LoRA技術:輕量化微調,提升系統效率

- Text as Hub:創新架構,透過語意進行模型分類

研究結果與討論

生成影像品質評估

本研究透過真實性與多樣性兩個面向,對14種白血球類別的生成影像進行品質評估。

| 細胞種類 | FID指標 | CMMD指標 |

|---|---|---|

| Smudge Cells | 34.33 | 0.0634 |

| Promyelocyte | 43.13 | 0.1591 |

| NRBC | 35.88 | 0.1467 |

| Neutrophilic Myelocyte | 37.52 | 0.1598 |

| Neutrophilic Metamyelocyte | 35.31 | 0.1491 |

| Neutrophil Segment | 34.50 | 0.1235 |

| Monocyte | 32.32 | 0.1220 |

| Lymphocyte | 31.12 | 0.1518 |

| GIANT PLT | 38.51 | 0.1661 |

| Eosinophils | 34.77 | 0.1392 |

| Blast | 31.44 | 0.1321 |

| Basophils | 35.89 | 0.0878 |

| Band | 35.23 | 0.1234 |

| Atypical lymphocyte | 37.43 | 0.1678 |

模型效能與專家比較

CLIP模型

14類白血球分類準確率

檢驗人員1

年資5年以上

檢驗人員2

年資5年以上

檢驗人員3

年資5年

LLaMA模型生成敘述評估

透過Soft Cosine Similarity評估生成文字描述與標準答案的語意相似度,分數高於0.7視為正確,本系統在醫學描述生成方面表現優異,能夠提供準確的分類依據說明。

Android App 實作成果

為了讓白血球分類系統更貼近實際應用,我們設計並開發了 Android 應用程式,讓使用者可以透過手機進行白血球影像辨識。 App 提供拍照、影像上傳、分類結果查看與紀錄瀏覽等功能,操作簡單、流程清晰,方便使用者快速完成分析。

主要功能特色

影像拍攝與上傳

使用者可透過手機相機拍攝白血球顯微影像,App 將照片傳送至後端伺服器進行分析處理。

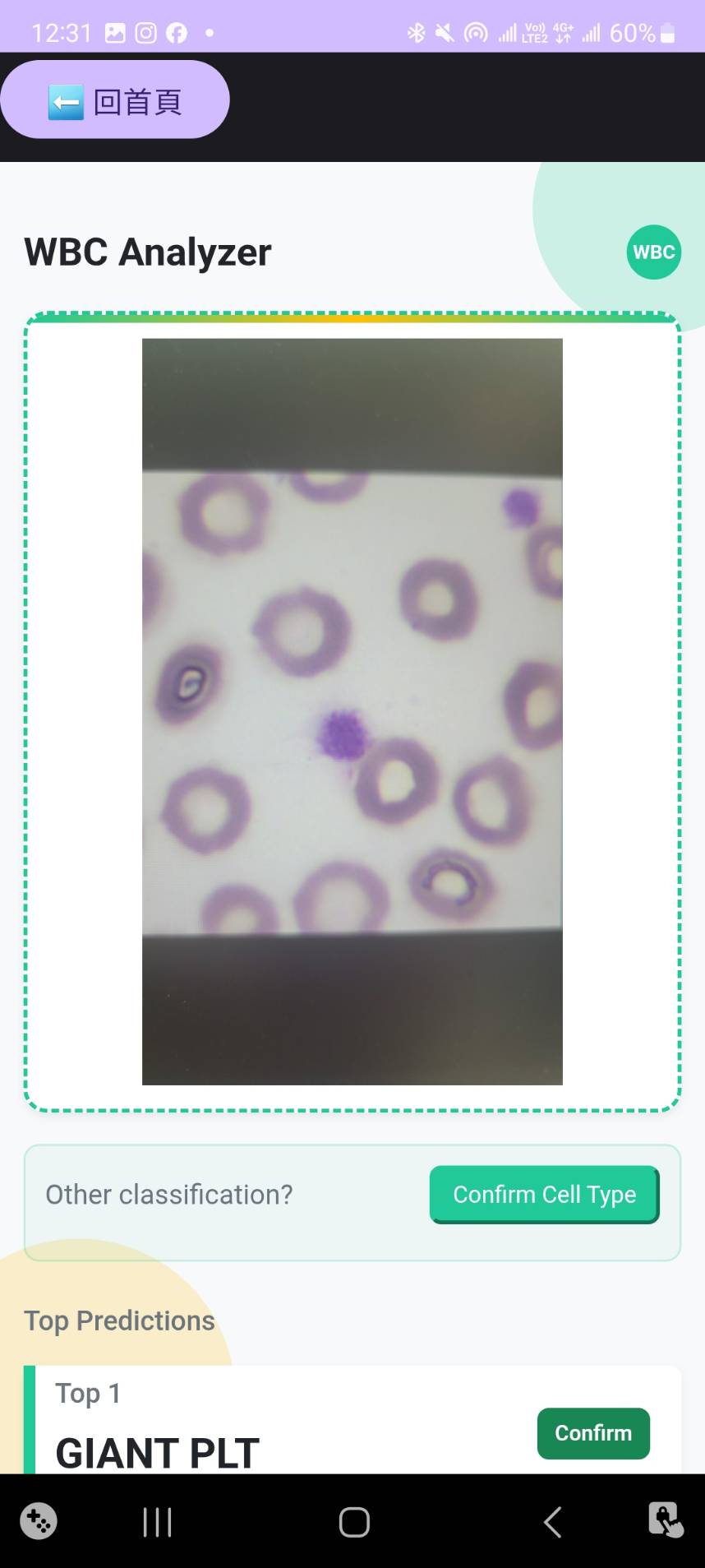

分類結果展示

系統回傳分類結果(共 14 類白血球),並搭配 LLaMA 模型生成的說明文字,協助使用者理解判斷依據。

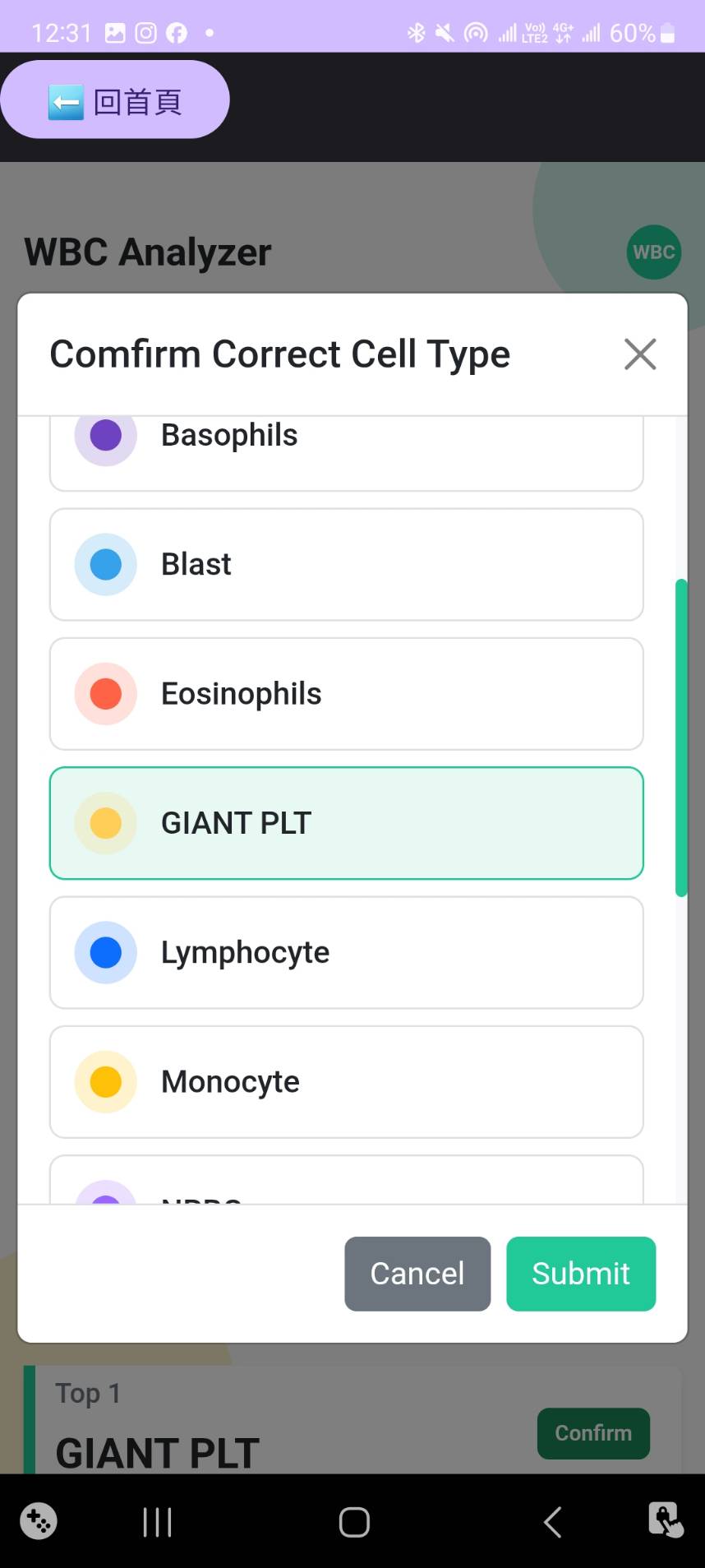

人工結果確認

使用者可檢視與修正 AI 分類結果,提供回饋機制以強化模型準確度。

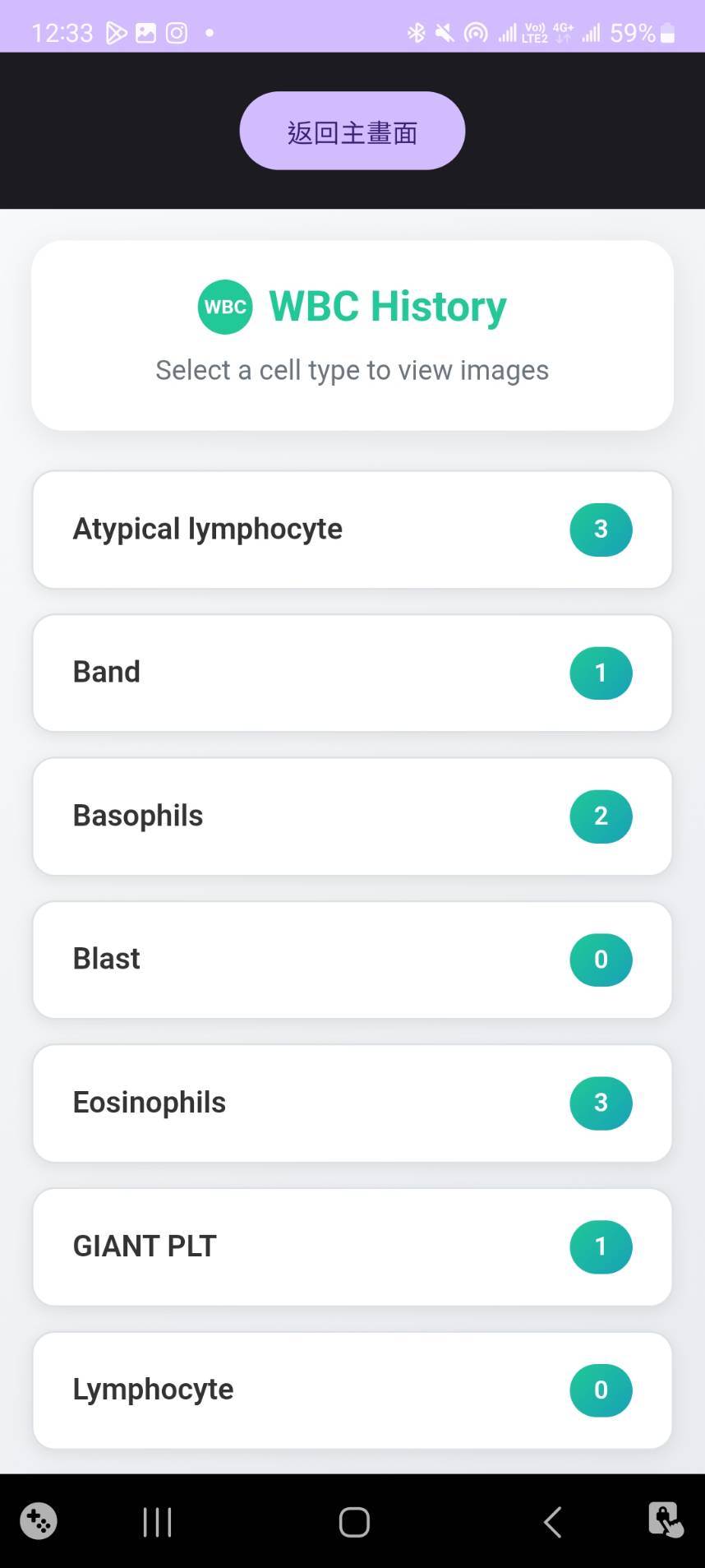

分類紀錄瀏覽

以白血球類別進行分類,並以卡片形式呈現過去影像與拍攝時間,方便比對與回顧。

使用流程展示

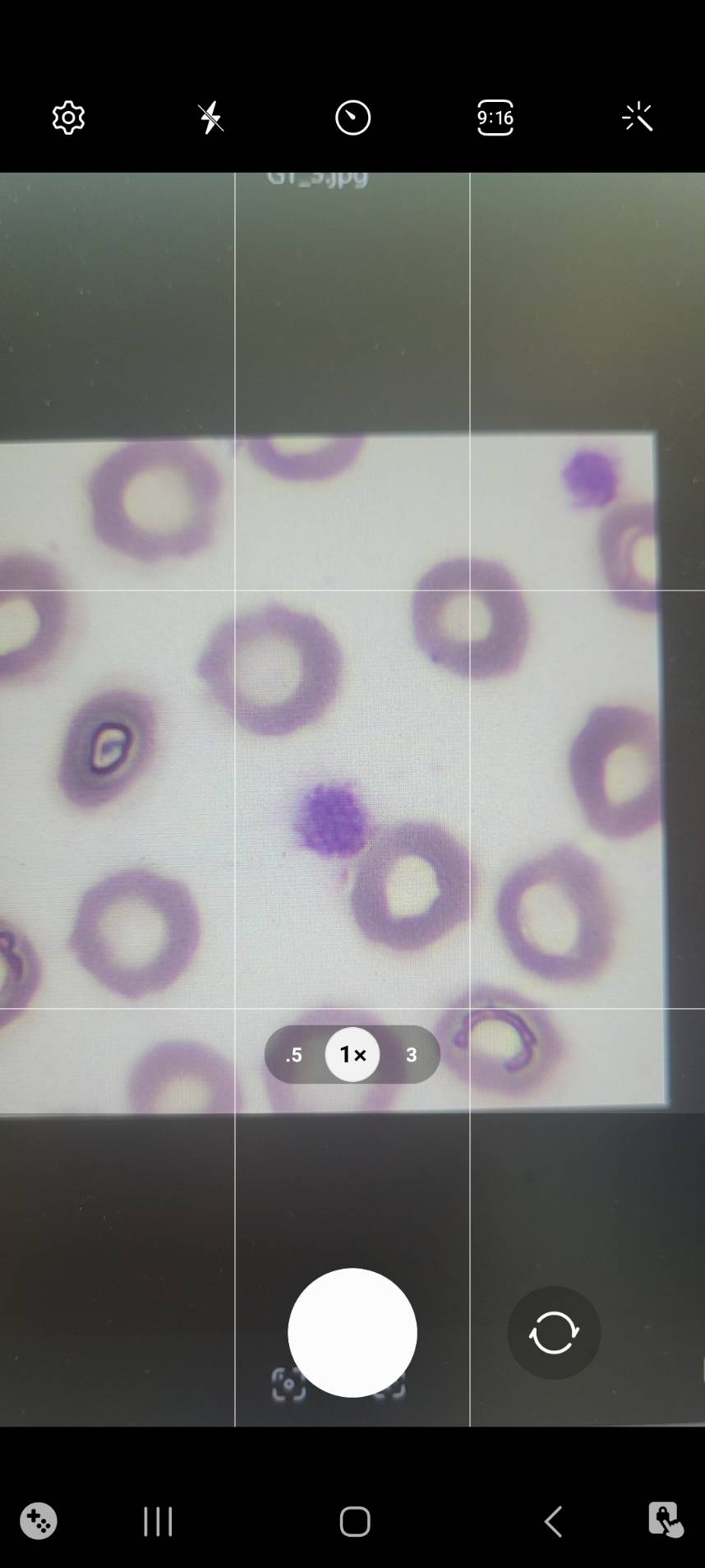

拍照上傳

透過手機拍攝顯微影像後,自動上傳至後端進行分析

分類結果

顯示模型預測的白血球類型與文字說明

結果確認

使用者可確認或修改系統預測結果,回饋系統提升準確性

分類紀錄

依照白血球類別瀏覽過去影像,並顯示對應的拍攝時間

系統優勢與貢獻

設備成本降低

僅需檢驗人員使用手機結合顯微鏡拍照,大幅降低傳統昂貴設備的建置成本,促進偏鄉醫療發展。與傳統高價儀器DI-60相比,本系統在六類白血球分類上已超越該設備效能。

教育訓練功能

採用創新的Text as Hub框架,同步生成細胞醫學描述,幫助資淺檢驗人員或醫學生快速掌握細胞特徵和分類原因,在提升效率的同時促進學習。

解決人力不足

有效解決各醫院國家認證細胞型態分類臨床專家人員不足的問題,減緩資深檢驗人員的工作負擔,提供24小時不間斷的專業級分類服務。

AI輔助診斷

結合大型語言模型輸出分類依據,通過多項指標評估達標,為醫療決策提供可靠的AI輔助支援,提升診斷品質與一致性。